Zum Profil

Seminar: Robuste Bild-Deskriptoren für schwierigen Sichtbedingungen

Organisatorisches

Unverbindliche Interessensbekundung:

Formlose E-Mail mit Betreff „[Seminar-WS2425] Interesse <Name>“ an mmints@uni-koblenz.de bis Sonntag, 25.08.2024

Weitere Informationen:

Die Anmeldung erfolgt über Klips (https://klips.uni-koblenz.de/v/159677 )

Das erste Treffen findet am 30.10. statt.

Inhalt

Beschreibung

In diesem Seminar werden die Grundlagen und die neuesten Entwicklungen im Bereich der robusten Bild-Deskriptoren unter schwierigen Sichtbedingungen untersucht. Bild-Deskriptoren sind essenzielle Bausteine visueller Algorithmen wie visuelle simultane Lokalisierung und Kartierung (vSLAM), visuelle Platzierungserkennung (VPR) und visuelle Odometrie. Diese Algorithmen spielen eine zentrale Rolle in verschiedenen Anwendungen, von autonomen Fahrzeugen bis hin zur Robotik.

Motivation

Visuelle Systeme müssen auch unter schwierigen und wechselnden Bedingungen zuverlässig funktionieren, z.B. bei verschiedenen Wetterlagen, Tageszeiten und Lichtverhältnissen (wie Verschattungen durch Alleen oder Tunnel). Um diesen Herausforderungen zu begegnen, bedarf es robuster Bild-Deskriptoren, die unter diesen Bedingungen konsistente und verlässliche Informationen liefern können.

Fragestellungen im Seminar

Welche Deskriptoren/Algorithmen gibt es, die robust sind?

Untersuchung bestehender und neu entwickelter Deskriptoren, die speziell für schwierige Sichtbedingungen ausgelegt sind.Welche Anwendungen/Algorithmen nutzen robuste Deskriptoren?

Analyse von realen Anwendungen, in denen robuste Bild-Deskriptoren implementiert werden, und deren Einfluss auf die Leistung und Zuverlässigkeit dieser Systeme.Sensor-Fusion: Wie können multimodale Daten/Sensorsysteme in Algorithmen integriert werden?

Erforschung der Integration verschiedener Sensordaten (z.B. Lidar, Radar, GPS) zur Verbesserung der Robustheit und Genauigkeit visueller Algorithmen.Welche Deskriptoren gibt es für spezielle Kameras (Multispektral, Event-Kameras,…)?

Untersuchung der Nutzung und Vorteile spezialisierter Kamerasensoren und der entsprechenden Deskriptoren für spezielle Anwendungen und Bedingungen.Welche Datensätze und Benchmarks gibt es, die schwere Sichtbedingungen mit verschiedenen Sensoren umfassen, auf denen Deskriptoren getestet werden?

Bewertung und Vergleich verfügbarer Datensätze und Benchmarks, die zur Validierung und Optimierung von Bild-Deskriptoren unter schwierigen Sichtbedingungen genutzt werden können.

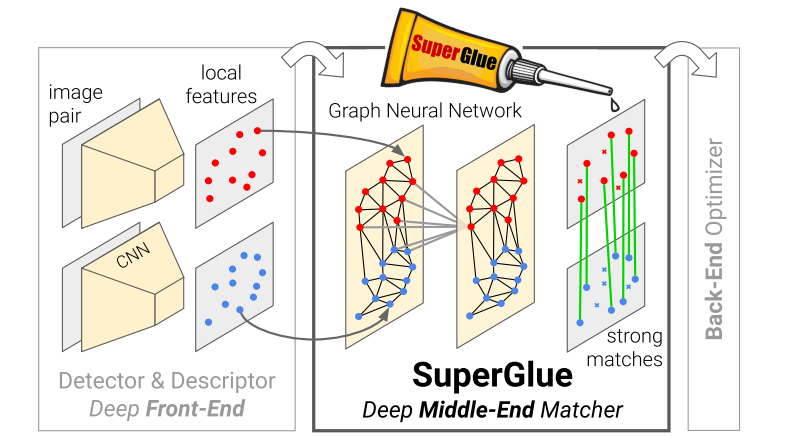

Bildquelle: Sarlin, P. E., DeTone, D., Malisiewicz, T., & Rabinovich, A. (2020). Superglue: Learning feature matching with graph neural networks. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition (pp. 4938-4947).