Zum Profil

Seminar

3D-Szenengraphen: Einsatz in der Robotik

Organisatorisches

Die Anmeldung erfolgt über Klips (Link)

Das erste Treffen findet am Donnerstag, den 18.04.2024 in A 120 um 10:00 c.t. statt.

Inhalt

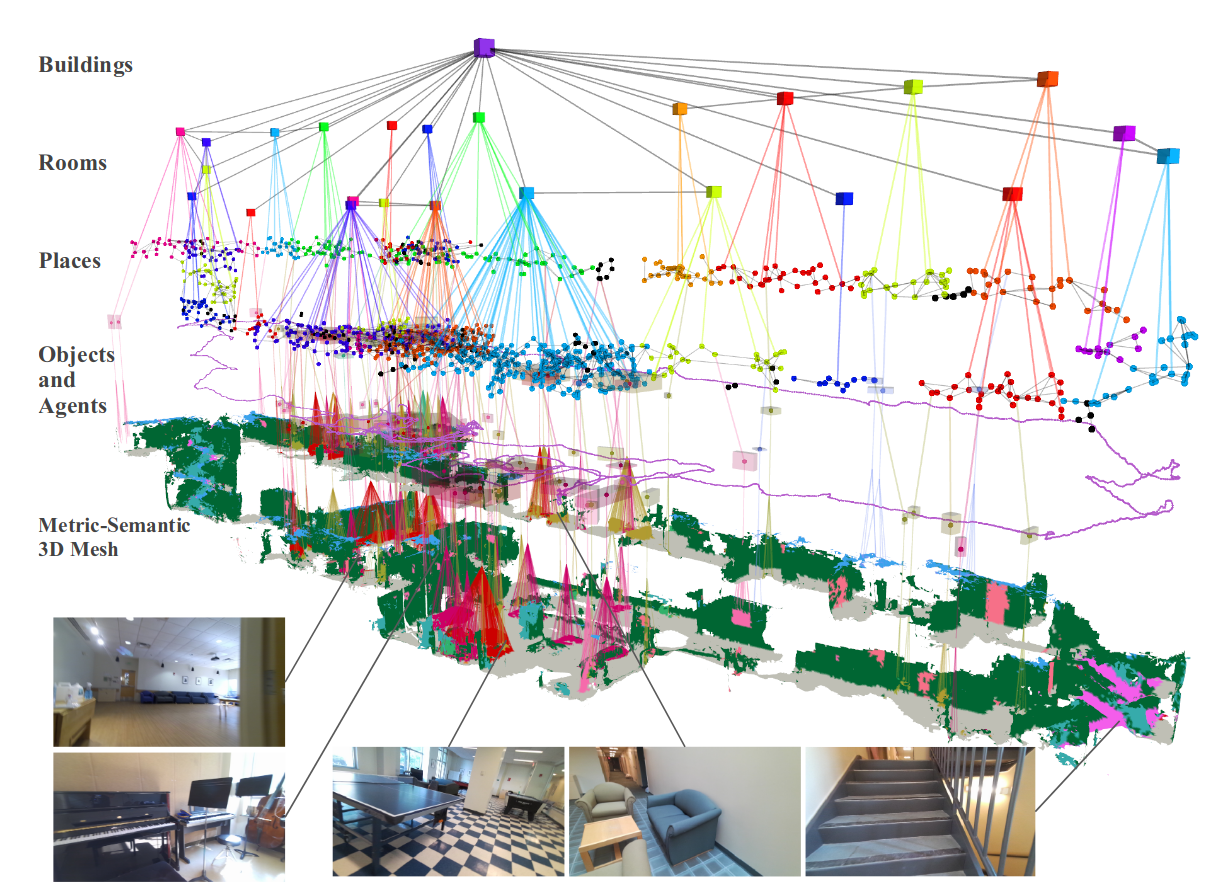

Szenengraphen sind Datenstrukturen, die zur Organisation und Verwaltung von dreidimensionalen Umweltdaten verwendet werden. In diesem Seminar werden wir untersuchen, wie Szenengraphen als Welt-Representation in der Robotik genutzt werden können, um die Wahrnehmung und Navigation von Robotern zu verbessern, insbesondere im Zusammenhang mit sensorbasierten Anwendungen. Durch den Einsatz solcher Graphen werden semantische Informationen, also die Bedeutung, der Nutzen oder auch die Relation von unterschiedlichen Objekten zu- und untereinander modelliert. Anhand theoretischer Diskussionen werden die Studierenden ein fundiertes Verständnis für deren Einsatz entwickeln. Die Grundlage für dieses Seminar bilden die Arbeiten von Armeni et al. [1], Wald et al. [2] und Hughes et al. [3].

[1] I. Armeni et al., “3D Scene Graph: A Structure for Unified Semantics, 3D Space, and Camera,” in 2019 IEEE/CVF International Conference on Computer Vision (ICCV), Seoul, Korea (South): IEEE, Oct. 2019, pp. 5663–5672. doi: 10.1109/ICCV.2019.00576.

[2] J. Wald, H. Dhamo, N. Navab, and F. Tombari, “Learning 3D Semantic Scene Graphs From 3D Indoor Reconstructions,” in 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA: IEEE, Jun. 2020, pp. 3960–3969. doi: 10.1109/CVPR42600.2020.00402.

[3] N. Hughes, Y. Chang, and L. Carlone, “Hydra: A Real-time Spatial Perception System for 3D Scene Graph Construction and Optimization,” in Robotics: Science and Systems XVIII, Robotics: Science and Systems Foundation, Jun. 2022. doi: 10.15607/RSS.2022.XVIII.050.

Bildquelle: N. Hughes, Y. Chang, and L. Carlone, “Hydra: A Real-time Spatial Perception System for 3D Scene Graph Construction and Optimization,” in Robotics: Science and Systems XVIII, Robotics: Science and Systems Foundation, Jun. 2022. doi: 10.15607/RSS.2022.XVIII.050.